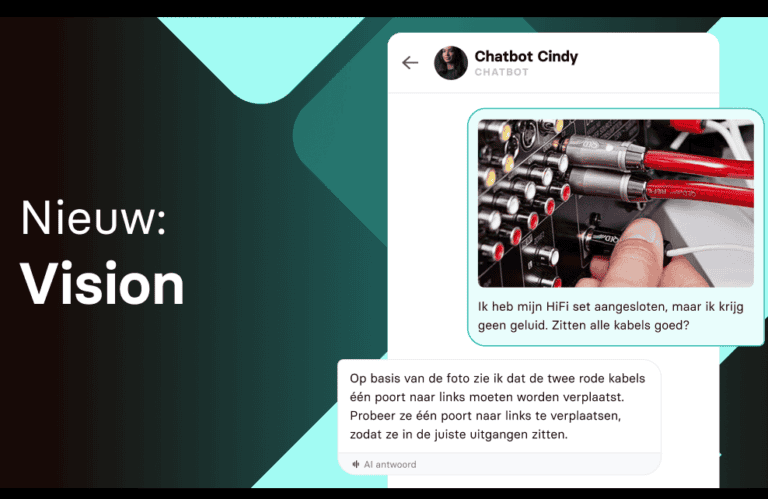

Grote generieke chatbots begrijpen afbeeldingen al wat langer. Watermelon maakt dit nu ook mogelijk voor een meer AI-gedreven klantenservice.

Watermelon bouwt het eigen aanbod grotendeels op GPT-4o van OpenAI. Met dat model leunt de AI-speler zwaar op de verbeterde multimodaliteit ten opzichte van eerdere LLM’s. Dat wil zeggen: het kan tekst, geluid en beelden beter interpreteren dan ooit en deze informatie met elkaar combineren. Watermelon, dat organisaties hun eigen GPT-4o-gebaseerde chatbot laat bouwen, richt zich specifiek op Vision. Het laat AI-chatbots van klantenservices meekijken met gebruikers zonder extra handelingen te vereisen.

Veel mogelijkheden

CEO en oprichter van het Utrechtste Watermelon Alexander Wijninga stipt aan hoe Vision de functionaliteit van AI vergroot. “Denk bijvoorbeeld aan een dierenarts die een foto van een plekje op de huid van een huisdier ontvangt, of aan een technisch bedrijf dat op basis van een foto kan bepalen welk soort reparatie nodig is. Door Vision kunnen chatbots nu meer vragen beantwoorden, wanneer beeldmateriaal cruciaal is om tot een oplossing te komen.”

De belofte is dat een klant na het uploaden van een foto direct vanuit de chatbot een antwoord op een bijbehorende vraag krijgt; dit brengt de interactie tussen bedrijven en klanten “naar een nieuw niveau”, belooft Wijninga.

Het zal niet bij de huidige functionaliteit blijven, belooft Watermelon. Zo kan de huidige Vision-variant nog niet goed objecten binnen een afbeelding plaatsen. “Een simpel voorbeeld: als je een foto van een kamer met een stoel deelt met een chatbot en vraagt waar de stoel staat, dan kan de chatbot dat nu nog niet goed beantwoorden”, legt Wijninga uit.