OpenAI heeft zojuist GPT-4.5, een nieuw model om ChatGPT te draaien, aangekondigd in een livestream. Het is het grootste model dat OpenAI heeft uitgebracht, hoewel het niet deelt hoeveel parameters deze LLM precies bezit.

OpenAI spreekt over twee grote stappen vooruit als het om GPT-4.5 gaat. Allereerst maakt het model gebruik van unsupervised learning, dat inhoudt dat de LLM zelf ontdekt hoe het patronen moet herkennen zonder dat een mens moet aangeven of die patronen correct zijn. Daarnaast redeneert GPT-4.5 beter dan ooit, waarbij OpenAI veel lessen zal hebben geleerd met eerdere redeneermodellen als o1 en o3-mini.

Redeneren voor moeilijke kwesties

Deze verbeteringen bieden voordelen voor zowel complexe materie als doorsnee vragen. Redeneren geeft het model namelijk extra output-tokens om een antwoord te genereren, waarbij de precieze details hiervan door OpenAI worden afgeschermd. DeepSeek, Gemini Flash Thinking en Claude 3.7 Sonnet daarentegen laten dit ‘denkproces’ juist in zijn volledigheid zien. Unsupervised learning versterkt juist de “intuïtie” die GPT-4.5 van huis uit zou moeten hebben.

Een groot probleem van LLM’s is dat ze geen werkelijk concept van de realiteit hebben. OpenAI verwijst naar een grotere “wereldkennis” van GPT-4.5, wijzend op het feit dat het model vaker aannames doet die aansluiten op de werkelijkheid. Daarnaast stelt de AI-maker dat de LLM niet stapsgewijs nadenkt zoals o1 dat doet, maar “inherent slimmer” is. GPT-4.5 is dus geen reasoning-model zoals OpenAI o1 of DeepSeek R1.

Synthetische data

Door de betere intuïtie zou GPT-4.5 natuurlijk aanvoelen om mee te converseren ten opzichte van eerdere modellen. De uitgelichte toepassingen sluiten hierop aan. Denk aan hulp bij het schrijven van teksten, programmeren of het oplossen van praktische problemen.

Ondanks het feit dat o1 juist uitgebreide, ‘doordachte’ antwoorden levert, laat OpenAI voorbeelden van GPT-4.5-outputs zien die toegankelijker gestructureerd zijn. Oftewel: als lezer word je beter begeleid door de tekst dan voorheen.

Veel is gezegd en geschreven over AI-destillatie, een proces waarbij een groter model een kleiner model leert hoe het moet antwoorden. Zo slagen destillaties van DeepSeek R1 met veel minder parameters (671 miljard voor het volledige model versus soms slechts 1,5 of 8 miljard) erin om op een soortgelijke wijze te redeneren als het volledige model. DeepSeek werd zelfs door OpenAI beschuldigd van API-misbruik door antwoorden te genereren en er een eigen LLM op te trainen, iets dat in strijd met de gebruikersovereenkomst is. OpenAI koos juist voor een tegengestelde richting, maar een vergelijkbaar proces: kleine modellen hielpen GPT-4.5 juist om betere outputs te genereren met hun eigen outputs als synthetische data.

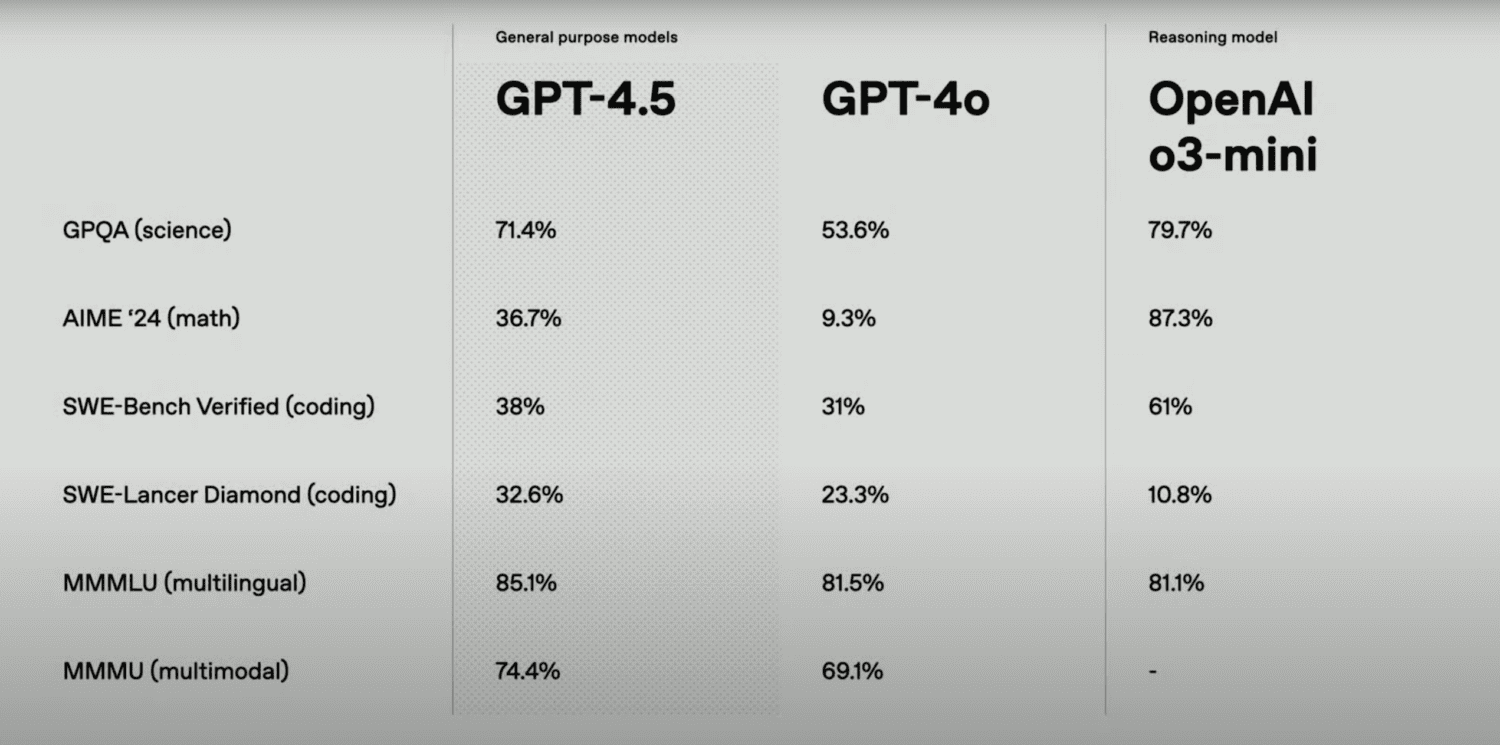

Benchmarks

OpenAI presenteerde alvast verschillende benchmarkresultaten voor GPT-4.5. Met SimpleQA worden LLM’s op de proef gesteld met allerlei soorten vragen. GPT-4.5 scoorde hier 62,5 procent, aanzienlijk hoger dan GPT-4o (38,6%), o1 (47%) en o3-mini (15%). Ook hallucineerde het minder dan de concurrentie, met 37,1 procent tegenover 61,0 procent voor GPT-4o, 44 procent voor o1 en 80,3 procent voor o3-mini.

Daarnaast haakt OpenAI in op de informele term van de dag onder AI-testers: “vibes”. Deze draaien om de gevoelsmatige krachten en zwakke plekken van een LLM, die niet altijd in een benchmark te vangen zijn. Een bekend voorbeeld is Anthropic’s Claude, dat veelal populairder is dan de testresultaten doen vermoeden. LM Arena test daarom twee verschillende modellen naast elkaar en laat gebruikers kiezen welk antwoord zij preferen. Via een vergelijkbare “vibe”-evaluatie blijkt GPT-4.5 in een blinde smaaktest betekenisvol geliefder dan voorganger GPT-4o. De echte test zal echter de massale inzet van het nieuwe model onder ChatGPT-gebruikers zijn.

Post-training perikelen

Omdat OpenAI nog nooit een groter model had getraind, moest het sommige zaken over een andere boeg gooien. Een geheel nieuwe opzet was nodig voor de post-trainingfase omdat de verhouding tussen de beschikbare data en het aantal parameters anders was. Voorheen was er altijd wel meer data om op te draaien, terwijl de parameters evenredig meegroeiden. De data is “op”, om het simpel te zeggen, want elke AI-bouwer heeft het volledige toegankelijke internet geraadpleegd in eerdere trainingruns. We hebben al eerder geschreven over de problemen die dit opleverde voor “Orion”, de codenaam voor wat nu GPT-4.5 blijkt te zijn.

De nieuwe methodiek om dit probleem aan te pakken draait om supervised fine-tuning (SFT) en reinforcement learning through human feedback (RLHF). Dit zijn bekende technieken, maar OpenAI denkt dat het GPT-4.5 beter dan welk eerder model dan ook gereed heeft gemaakt voor productie. Daarom is het niet zo verwonderlijk dat de previewfase van een korte duur is.

Ook pre-training, het loslaten van data op het model om de parameters te bepalen, is op de schop gegaan. OpenAI maakte “agressief” gebruik van pre-training op lage precisie, dat minder rekenkracht kost dan bij een hogere accuratesse. Daarnaast werd GPT-4.5 in meerdere datacenters tegelijk getraind, een unicum voor zover wij weten onder LLM’s.

Beschikbaarheid

GPT-4.5 wordt beschikbaar gesteld als research preview-model voor ChatGPT Pro-gebruikers en ontwikkelaars via de API. Plus- en Team-gebruikers krijgen toegang vanaf volgende week.

De release van GPT-4.5 komt niet geheel onverwacht. Een aankondiging op de Android-app van ChatGPT maakte al duidelijk dat er een previewversie beschikbaar zou komen van dit model.

Lees ook: OpenAI komt met ‘deep research’; het antwoord op DeepSeek?