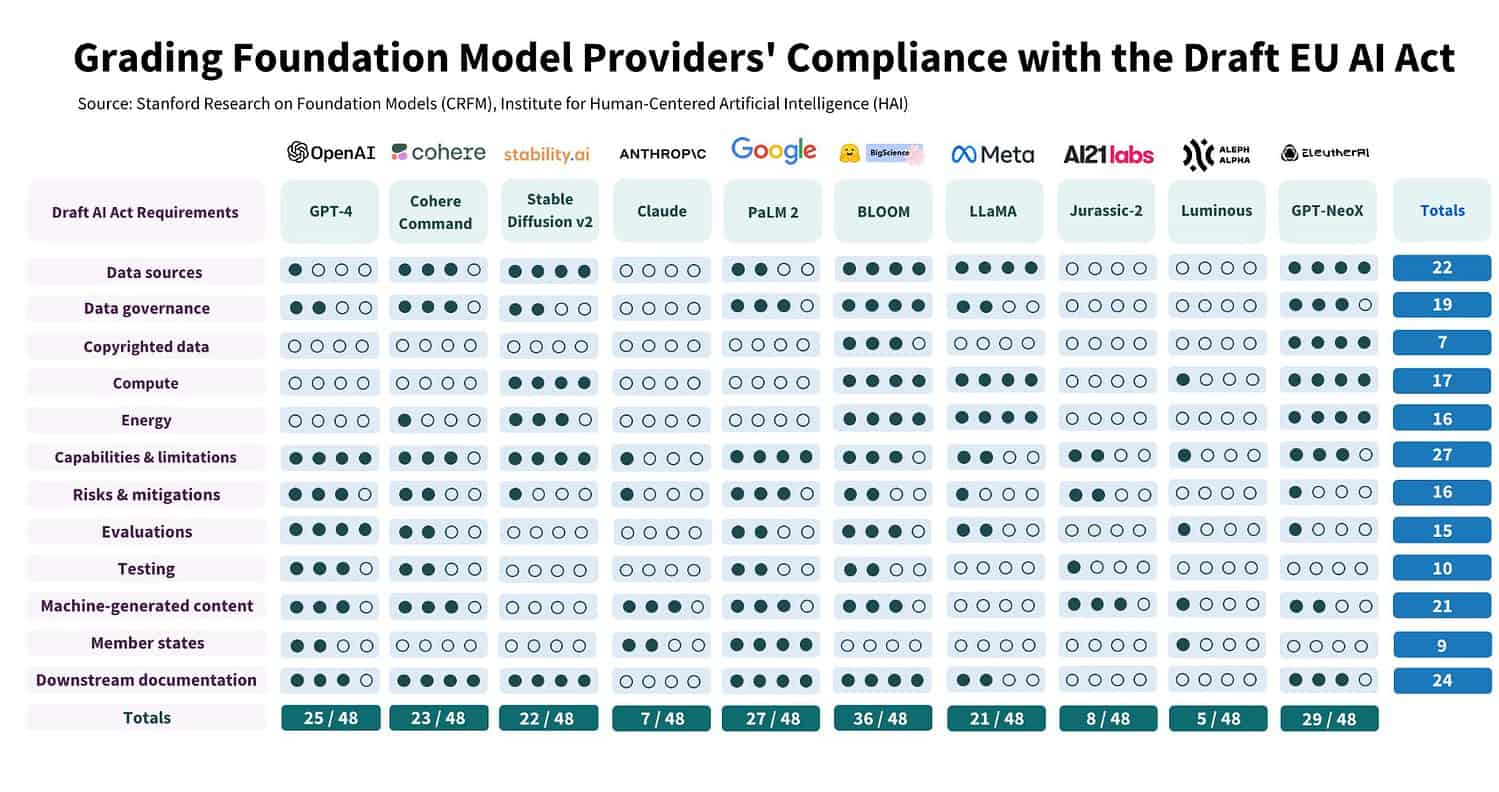

Nu een voorlopige versie van de AI Act is goedgekeurd, kunnen AI-ontwikkelaars alvast beginnen om hun modellen in orde te krijgen. Onderzoekers van Stanford University hebben een deel van het werk voor zich genomen. Zij komen tot de conclusie dat het model BLOOM van BigScience momenteel het beste scoort. Met een 36 op 48 is het nog niet tot in de puntjes verfijnt, maar het is wel een scherp contrast met de modellen Claude, Jurassic-2 en Luminous die nog geen tien punten behalen.

Wetenschappers bij Stanford University onderzochten of foundation models voldoen aan de AI Act. De conclusie is duidelijk: “Dat gebeurt grotendeels niet.” De grootste struikelblokken liggen in het transparant communiceren over gebruikte bronnen in het trainen van de modellen en het aanduiden van de belangrijkste eigenschappen van de modellen zelf.

Tip: EU stemt over AI Act-ontwerp: moet ChatGPT veranderen?

Een verloren zaak is het echter ook niet, want de onderzoekers stellen wel dat de wet haalbaar is voor de geanalyseerde foundation models. Al zal het voor de ene partij harder ploegen zijn dan voor de ander.

Zwakste model werkt samen met HPE

De bedrijven AI21 Labs, Aleph Alpha en Anthropic hebben hun modellen bijvoorbeeld nog niet eens voor een kwart op orde. Dat lijkt op het eerste gezicht niet om de meest spraakmakende taalmodellen te gaan. Graven we wat dieper dan zien we dat Luminous toch alvast een contract vastheeft met HPE Greenlake for Language Models. Terwijl dit foundation model met een 5 op 48 de slechtste score wegzet in de studie.

De studie baseert zich voor het totaalpunt op twaalf onderdelen die allemaal aandacht zullen krijgen onder de AI Act. Op ieder onderdeel kan het foundation model een score bemachtigen tussen 0, heel zwak, tot 4, het best mogelijk. Luminous scoort op de onderdelen ‘compute’, ‘mogelijkheden & limitaties’, ‘evaluaties’, ‘automatisch gegenereerde content’ en ‘lidstaten’ een één op vier. In totaal sleept het zo vijf punten binnen. De punten behandelen of het bedrijf transparant is over deze zaken. ‘Compute’ is bijvoorbeeld een maatstaf om te controleren of de modelgrootte, computerpower en trainingstijd voor het foundation model achter Luminous bekend zijn.

Verder scoorden het model nul punten voor de categorieën ‘databronnen’, ‘data governance’, ‘auteursrechtelijk werk’, ‘energieconsumptie’, ‘risicobeperkingen’, ‘testing’ en ‘downstream documentation’.

Eén model al driekwart in orde

De toekomt ziet er rooskleuriger uit voor het model BLOOM van BigScience. Dat model scoort 36 op 48 en is dus al meer dan driekwart in orde met de aankomende regels. Het gaat om een opensource-model dat gratis ter beschikking staat voor onderzoekers. Bovendien spreekt het taalmodel meerdere talen.

De vaak ophefmakende modellen van OpenAI, Google en Meta, scoren allemaal rond de vijftig procent. Meta scoort nog onder de grens (21/48) en heeft voornamelijk nog werk op vlak van transparantie over auteursrechtelijke bronnen, de testwijze, machine-generated content en de lidstaten van de EU waarin het model beschikbaar is. OpenAI werd beoordeeld aan de hand van GPT-4 (25/48) en dient nog te sleutelen aan de inzage in auteursrechtelijke bronnen, de rekenkracht en de energiecapaciteit die nodig was voor de training. Google heeft precies dezelfde werkpunten, maar scoort met PaLM 2 wel net beter op enkele andere categorieën en scoort daarom 27 op 48.

‘AI Act haalbaar voor foundation models’

Met het onderzoek toont Stanford University wel aan dat het goedgekeurde wetsvoorstel haalbaar is. “Uit ons onderzoek blijkt dat het voor aanbieders van foundation modellen op dit moment haalbaar is om te voldoen aan de AI-wet.” De onderzoekers nemen het zelfs een stapje verder en stellen dat de regels bevorderen dat het volledige ecosysteem transparanter wordt.

Dat schijnt een interessant licht op de voornamelijk negatieve kritiek die het wetsvoorstel al kreeg. Die kritiek werd zelfs rechtstreeks aan het adres van de Europese Commissie geleverd in een open brief. 150 wetenschappers, managers van EU-bedrijven en onderzoekers schaarden zich daarin achter het standpunt dat de AI Act voornamelijk een rem zal zetten op technologische ontwikkelingen en het concurrentievermogen van de EU. De angst heerst voornamelijk dat AI-ontwikkelaars weg zullen trekken uit de EU.

Het is interessant om te zien dat een wetenschappelijk onderzoek nu de andere zijde van het verhaal ondersteunt. De Europese Commissie besloot eerder al dat de aantijgingen niet op veel concreets gebaseerd waren. Volgens de Commissie sprongen veel bedrijven gewoon op het denkpatroon van enkele kleine bedrijven. Een onderzoek van een verdienstelijke universiteit zet meer kracht bij de legitimering van de aankomende AI Act.