HP Enterprise heeft laten weten dat het bedrijf een onderzoekssubsidie heeft gekregen van het Amerikaanse Ministerie van Energie. Deze subsidie wordt toegekend om de ontwikkeling van The Machine te ondersteunen. The Machine is het grootste project dat HPE naar eigen zeggen ooit heeft opgezet. Het is een zogeheten exascale-computer, met een rekenkracht die tot nu toe onmogelijk was. Hij moet op termijn ingezet gaan worden voor onder andere simulatie- en modelleringsapplicaties die op dit moment nog niet mogelijk zijn met de huidige technologie.

The Machine – door HPE eerder dit jaar geïntroduceerd – maakt gebruik van een fundamenteel andere manier van dataverwerking. Waar we tot nu toe gewend zijn dat dit gebeurt middels een combinatie van processing (CPU) en werkgeheugen (RAM), maakt The Machine gebruik van wat HPE Memory-Driven Computing noemt. De twee onderdelen zijn als het ware bij elkaar gepakt. HP is overigens al geruime tijd bezig met het ontwikkelen van deze technologie. De eerste geluiden rondom de zogeheten memristor-technologie dateren al van zo’n 10 jaar geleden.

Combinatie van processing en geheugen

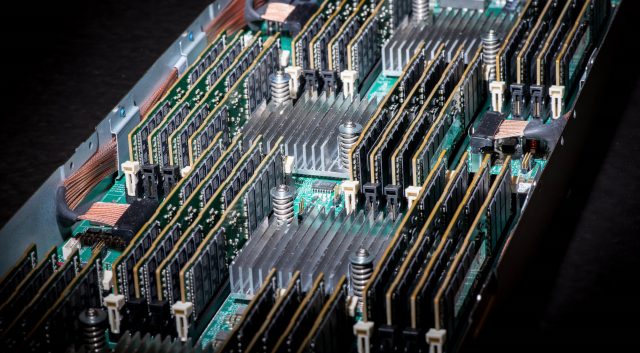

Het werkgeheugen van een systeem is zonder uitzondering het snelste onderdeel. Een nadeel ervan is dat het vluchtig is. Zodra de stroom van een systeem gaat, is de informatie die in het werkgeheugen staat verdwenen. In The Machine is het de bedoeling dat het voordeel van werkgeheugen (de snelheid) gecombineerd wordt met de mogelijkheid om ook data vast te houden. Op dit moment heeft het prototype de beschikking over niet minder dan 160 TB aan geheugen. Dit kan makkelijk doorschalen naar een hoeveelheid waar wij ons op dit moment in ieder geval geen voorstelling van kunnen maken: 4096 yottabytes. Een yottabyte is een 1 met 24 nullen.

Het doel van The Machine is zoals al aangegeven het mogelijk maken van zeer complexe berekeningen binnen een acceptabele tijd. De nadruk ligt met name op big data, waar bij veel bedrijven steeds meer focus op komt en mee gedaan wordt. Er wordt immers steeds meer data gegenereerd. Hiervoor is de huidige technologie volgens HPE simpelweg niet geschikt en moet er naar een nieuwe manier van dataverwerking gekeken worden.

Bill Mannel, Vice President en General Manager HPC Segment Solutions bij HPE, is niet verrassend in zijn nopjes met de onderzoekssubsidie:

“We zijn blij met de kans om een technische blauwdruk voor een exascale systeem te verzorgen. Dit systeem verwerkt data sneller dan elke bestaande supercomputer en staat voor nieuwe mogelijkheden in computing en wetenschap”

“Onze nieuwe Memory-Driven Computing-architectuur, gecombineerd met onze expertise in HPC en partneromgeving, zorgt dat we de eerste exascale supercomputer kunnen leveren in de Verenigde Staten.”