Nvidia heeft een aantal nieuwe deep learning tools voor onderzoekers en ontwikkelaars aangekondigd, waaronder de beschikbaarheid van Kubernetes voor gpu’s. Het deed die aankondigingen tijdens de Computer Vision and Pattern Recognition Conference in Salt Lake City.

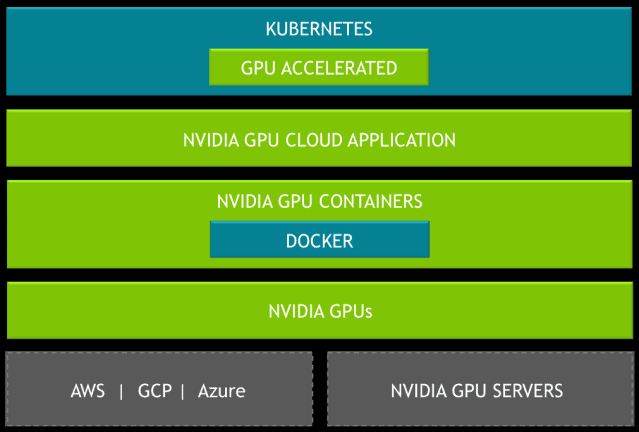

Met een toenemend aantal door AI aangedreven applicaties en diensten en de brede beschikbaarheid van gpu’s in de publieke cloud, was het volgens Nvidia noodzakelijk om Kubernetes voor zijn gpu’s beschikbaar te maken.

Met Kubernetes voor Nvidia-gpu’s kunnen ontwikkelaars deep learning-trainingen en inferentietoepassingen naadloos opschalen naar multi-cloud gpu-clusters. Het laat toe om de uitrol, het onderhoud, de planning en werking van meerdere GPU-versnelde toepassingscontainers te automatiseren.

Ontwikkelaars kunnen onmiddellijk aan de slag met de release candidate van Kubernetes voor Nvidia-gpu’s.

Meer tools

Daarnaast heeft Nvidia ook TensorRT 4 algemeen beschikbaar gemaakt. TensorRT 4 versnelt inferentietoepassingen zoals neurale machinevertaling, aanbevelingssystemen, spraak- en beeldverwerkingstoepassingen op gpu’s. Nvidia kon in eigen tests snelheidswinsten van 45x tot 190x optekenen.

Nvidia heeft ook DALI beschikbaar gemaakt, een open source library die kan worden gebruikt om de data pipelines van deep learning frameworks te optimaliseren. Nvidia’s eigen datawetenschappers gebruikten de library om met AI-supercomputer DGX-2 tijdens de training een recordaantal van 15.000 beelden per seconde te verwerken.

Ten slotte werd nog een vroege versie van Apex gedemonstreerd. Dat is een open source extensie voor PyTorch om de trainingprestaties voor deep learning op Volta-gpu’s te maximaliseren. Apex is in bètaversie beschikbaar via GitHub.