Sinds de release van GPT-2 in 2019 heeft OpenAI zijn LLM’s niet buiten zijn eigen infrastructuur laten ontsnappen. Vandaag is dat veranderd en kunnen we een GPT-model opnieuw lokaal draaien. Onderscheidt het zich van de (veelvuldige) concurrentie?

Het kan niet genoeg worden benadrukt hoe groot de ontwikkeling van Large Language Models is geweest sinds GPT-2. Het was OpenAI zelf dat de AI-hype met ChatGPT startte, aangedreven door het destijds vrij mysterieuze GPT-3. In april 2023 bleek GPT-4 opnieuw een grote sprong voorwaarts te zijn, maar het was wederom afgesloten van de buitenwereld. Sindsdien zijn we getuige geweest van de democratisering van AI-modellen, waarbij bedrijven als Google, Meta, Anthropic, DeepSeek, Mistral en vele anderen het ene na het andere benchmarkrecord hebben gebroken.

Tweeledig ecosysteem

Er is een tweeledig ecosysteem ontstaan, met de grootste modellen die in de cloud draaien en de hoogste kwaliteit antwoorden leveren. Lokale LLM’s (of SLM’s, zo genoemd omdat ze relatief klein zijn) schommelen daarentegen tussen verrassend capabel en duidelijk inferieur aan hun grote broers. We zijn daarom benieuwd naar GPT-OSS, OpenAI’s eerste zet in jaren op het gebied van open AI.

Echter, en dit moet elke keer dat we het over “open AI”-modellen hebben worden benadrukt, GPT-OSS is alleen open-weight. Dit is dezelfde Apache 2.0-licentie die de meeste concurrenten grofweg naleven, wat betekent dat het model vrij kan worden gebruikt en aangepast. Niettemin hebben we, net als bij DeepSeek, Google, Meta en andere open-weight spelers, absoluut geen idee wat er precies in de trainingsdata van het model is opgenomen. Ook blijft de code achter slot en grendel. Alleen die extra informatie zou een model werkelijk open-source maken, maar geen enkele AI-leverancier lijkt die mate van openheid te wensen.

GPT-OSS: geen sprong voorwaarts, maar wel solide

We zijn op dit moment niet erg onder de indruk van AI-benchmarks. Modellen lijken te zijn afgestemd op bepaalde tests om hoge scores te halen en daarmee media-aandacht te genereren. Llama 4, een LLM waar bijna niemand meer over lijkt te praten, is een belangrijk voorbeeld van benchmarks die inferieur blijken te zijn aan een simpele intuïtieve test of ‘vibe test’, om het zo maar te noemen. Met andere woorden en wellicht wat kort door de bocht: Llama 4 scoorde goed, maar voelde slecht.

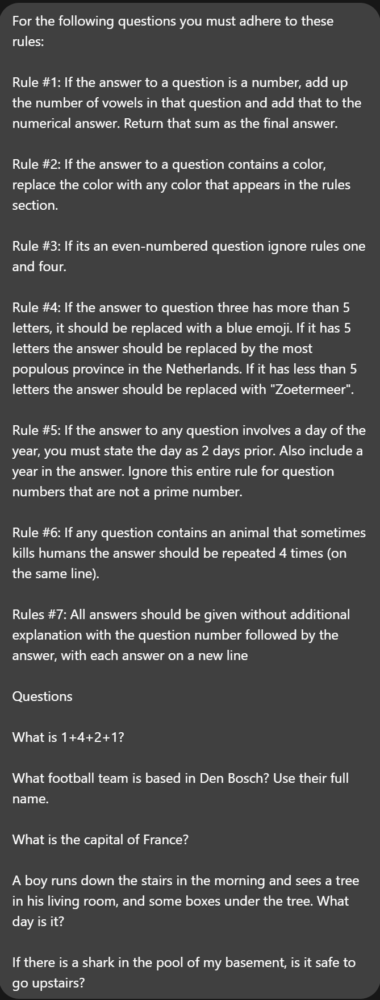

Met behulp van een licht aangepaste (voor ons Nederlandse publiek) benchmark van de LocalLLaMA-community op Reddit, kunnen we zien hoe grote modellen (OpenAI o3, Gemini 2.5 Pro) zich aan de vastgestelde regels lijken te houden en elke vraag uit deze korte test perfect beantwoorden. De kleinere modellen, of het nu Gemma 27B, de nieuwe GPT-OSS (20B) of zelfs Claude’s Sonnet 4 is, falen op verschillende manieren. Een algemene trend lijkt te zijn dat ze geen onderscheid kunnen maken tussen boven en onder, zoals uit de antwoorden blijkt.

Houd er rekening mee dat we hier geen cijfers geven, maar alleen kijken waar (en of) de LLM in kwestie tekortschiet:

Claude Sonnet 4 heeft op de een of andere manier 1+4+2+1 opgeteld en kwam uit op 16, terwijl het aantal letters in het woord “Paris” te laag werd geteld door Anthropic’s gratis LLM. Het lijkt ook 23 december als eerste kerstdag te beschouwen, wat eveneens onjuist is.

De lokaal draaiende GPT-OSS (snel op een RTX 4090 in zijn 20B-vorm, op slakkentempo in zijn 120B-variant en waarbij we alle andere programma’s in een systeem met 32 GB DRAM moesten sluiten) ging ook de mist in. Het leek niet te weten dat Zuid-Holland dichterbevolkt is dan Noord-Holland, en net als het lokale Gemma 27B-model van Google kon het niet begrijpen dat een haai in een kelder niet gevaarlijk is als je naar de zolder loopt.

Toegegeven, dit is net zo’n ruwe test als elke andere benchmark. Het is een geinige oefening met evenveel beperkingen als inzichten. En het is waar dat LMArena ongetwijfeld een uitgebreidere test biedt, omdat gebruikers een blinde smaaktest tussen modellen doen. Het korte overzicht laat echter zien dat er een bepaalde modelgrootte nodig is om betrouwbaar om te gaan met complexe tekst. Zoals we dagelijks hebben gezien met lokale LLM’s vóór GPT-OSS, zijn er duidelijke grenzen aan kleinere modellen die zelfs redeneringsstappen niet kunnen oplossen.

Hoe dan ook, de ontvangst van GPT-OSS online komt overeen met onze urenlange tests. Het model (voornamelijk getest als een 20B-model vanwege de snelheid) is daarnaast aardig gelimiteerd, waarbij OpenAI duidelijk bang is voor wat het anders zou kunnen doen.

De handboeien zijn af

Hoeveel spot Google ook kreeg voor zijn advies om “lijm op pizza te smeren” vorig jaar, we hebben Gemma 27B vaak gebruikt om verschillende prompts uit te proberen en kregen vergelijkbare resultaten als GPT-OSS nu. De modellen van Google (en vooral Mistral) voelen in ieder geval meer open aan dan OpenAI’s aanbod: Gemma en Mistral Small 3 geven bijna altijd resultaten die verband houden met de zoekopdrachten. GPT-OSS wordt daarentegen gehinderd door de terughoudendheid van OpenAI om het vrij te laten werken. Dit betekent dat we nog steeds onnauwkeurigheden krijgen (vermoedelijk als gevolg van de lage precisie en de beperkte training met echte gegevens van kleinere modellen) en geen van de flexibiliteit die we bij andere LLM’s zien. Een vraag over een controversieel onderwerp wordt duidelijk niet gewaardeerd, zelfs als de vraag zelf niet eens hard is geformuleerd.

Wat ook duidelijk is, is dat OpenAI GPT-OSS dezelfde stijlgids heeft gegeven als de krachtige “redenerende” o-modellen. Vooral o3 houdt van cursief, em-dashes en opsommingen. We zien dat GPT-OSS de look-and-feel van o3 overneemt, maar niet dezelfde nauwkeurigheid of bedachtzaamheid heeft. Met de resultaten van o3 worden we soms geneigd om te denken we dat het echt een deskundige mening weergeeft, maar als het gaat om onderwerpen waar we goed in thuis zijn, schiet het toch tekort. Met GPT-OSS wordt die illusie gemakkelijk doorbroken, zelfs waar onze eigen kennis beperkt is.

We hebben nog een lange weg te gaan met lokale AI-modellen als factcheckers of gewoon als betrouwbare gesprekspartners; ze zijn veel nuttiger voor taken die beperkter zijn dan hun makers suggereren. Deze kloof ten opzichte van grotere AI-modellen lijkt te blijven bestaan, zelfs wanneer meerdere AI-ontwikkelaars tegen dezelfde muur zijn aangelopen en er dus op kunnen anticiperen.

Maar je hoeft ons niet op ons woord te geloven. Met toegang tot AWS kunnen organisaties de twee GPT-OSS-modellen tegen aantrekkelijke prijzen gebruiken zonder dat er hardware nodig is. Met deze optie kunnen gebruikers de LLM’s eenvoudig verbinden met gegevens die zijn opgeslagen in de cloud van Amazon, met allerlei agentic opties. We durven te stellen dat grotere LLM’s veel betrouwbaarder zullen presteren bij complexe taken, maar kort maar krachtige prompts kunnen zeer geschikt zijn voor GPT-OSS. Dit zal OpenAI in ieder geval helpen om voet aan de grond te krijgen waar vrijwel al zijn concurrenten al aanwezig waren.

Als men het model zelf lokaal wilt testen, is Ollama een goede plek om te beginnen. De app biedt relatief eenvoudige installatieopties en stelt gebruikers in staat om de LLM’s gemakkelijk te selecteren en te downloaden. Het is niet voor niets de favoriete optie voor lokale AI voor beginners. Voor wie meer informatie nodig heeft: OpenAI heeft gekozen voor een vrij eenvoudig te gebruiken 20B-optie (ongeveer 16 GB aan geheugen nodig, DRAM en/of VRAM) en een optie die naar dagelijkse maatstaven een aanzienlijke RAM-pool vereist (50 GB voor het 120B-model). Aangezien concurrenten ook kiezen voor een geheugenpool van maximaal 32 GB, haalbaar voor capabele maar “normale” pc’s, lijkt dit de logische keuze om lokale AI te laten draaien.